Como ya vimos en la anterior entrada es bastante sencillo instalar un sistema SSO como authentik en nuestra infraestructura. De todas formas, crear un login centralizado no es más que una manera de tener que recordar menos contraseñas, pero el objetivo final es no tener que recordar más que unas pocas para poder acceder a todos los servicios, ¿qué hacemos si ya tenemos cuenta en alguno de los servicios más populares como office 365 o google? Lo suyo sería poder hacer login con estas credenciales en cualquier servicio, sea online o sea auto hospedado. Por suerte, authentik puede hacer uso de estos servicios externos de autenticación de manera «relativamente» sencilla. En este post os voy a explicar paso a paso (que sobre todo la parte a realizar con office es un poco liosa) cómo integrar el login de office 365 con authentik y así poder usarlo para acceder a nuestras aplicaciones (eso ya lo explicaremos en próximos posts).

Para poder realizar este tutorial debes tener:

- Servidor authentik instalado y configurado (con acceso como administrador)

- Cuenta de administrador office365 de tu organización

- Un poco de paciencia (esto nunca viene mal)

Paso 1: registrar una aplicación de microsoft entra

Entramos como administrador en portal.office.com

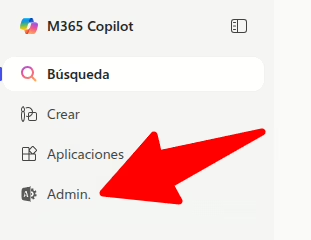

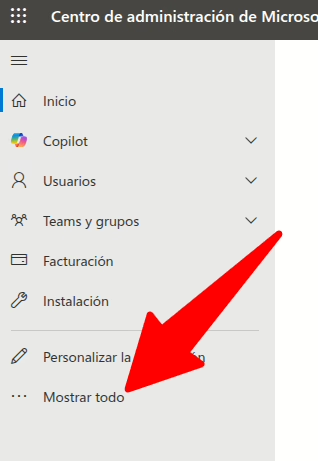

Pedimos que nos muestre todas las opciones (estos de MS suelen ocultarnos cosas)

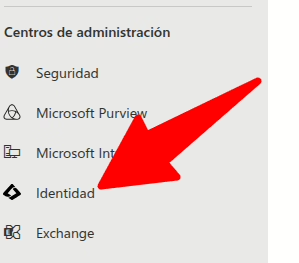

Seleccionamos la opción Identidad (nos llevará a entra)

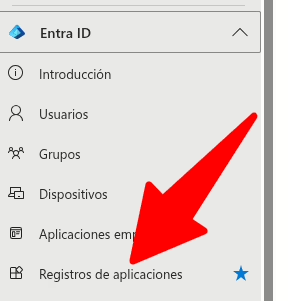

Seleccionamos la opción Registro de aplicaciones

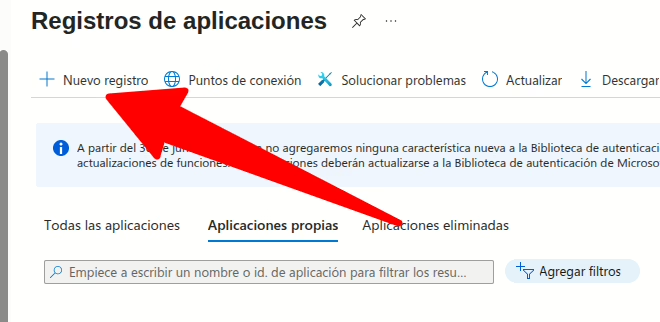

Y seleccionamos Nuevo registro

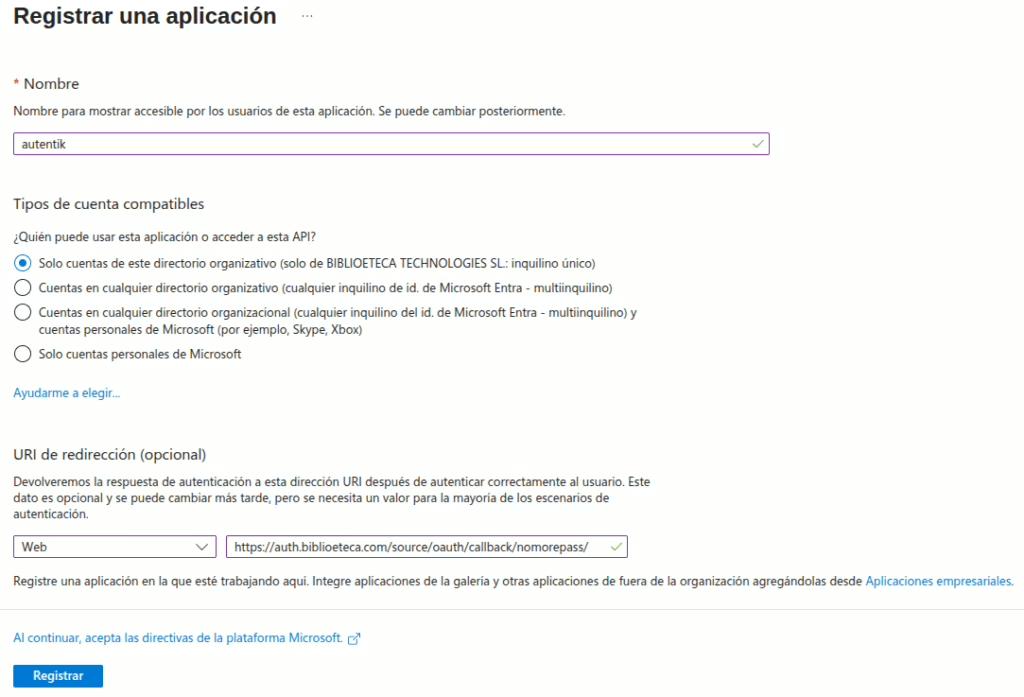

Y rellenamos los datos básicos (yo voy a llamar authentik a la nueva aplicación)

Hemos elegido que solo se pueda entrar con cuentas de nuestra organización, que será lo normal, aunque si queremos que cualquiera que tenga una cuenta de office365 pueda hacer logn tendremos que escoger una de las otras opciones. Atento a la ui de redirección, en principio tendrá el formato https://<direccion-de-tu-authentik>/source/oauth/callback/<nombre-de-fuente> Si no lo configuras ahora lo podrás hacer después cuando termines la configuración en authentik.

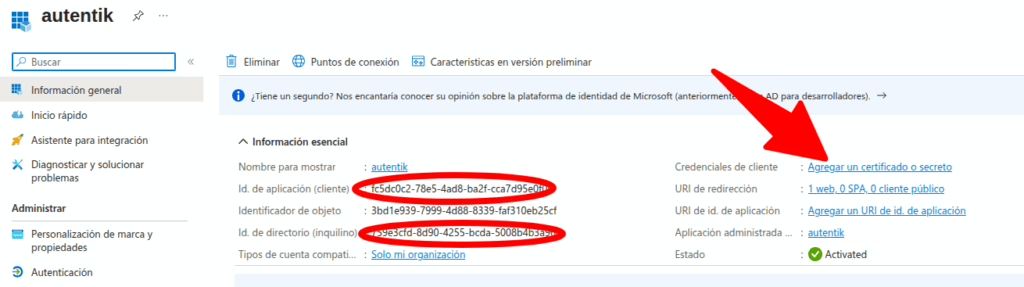

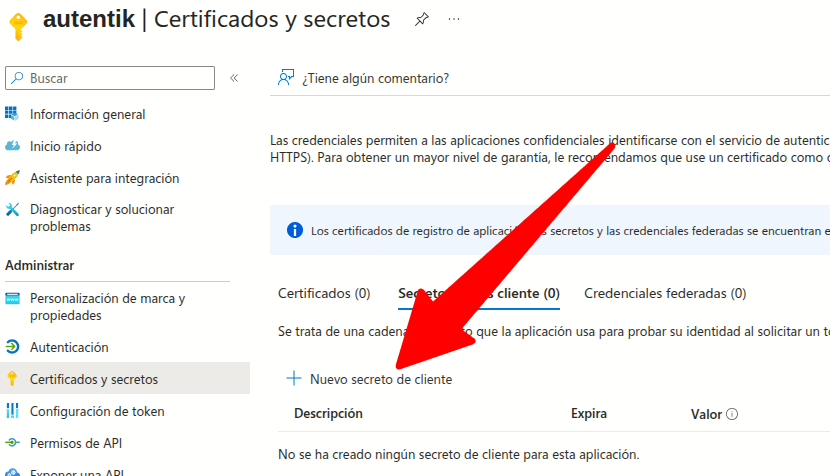

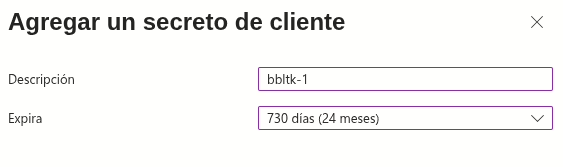

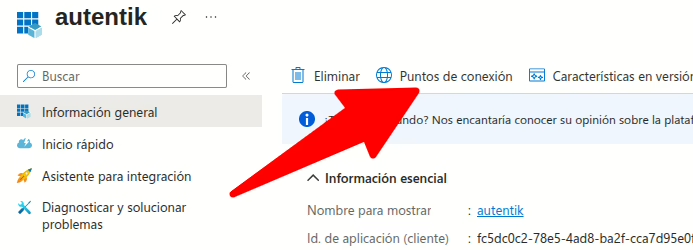

Anotamos los datos que vamos a necesitar de la aplicación y creamos un nuevo secreto:

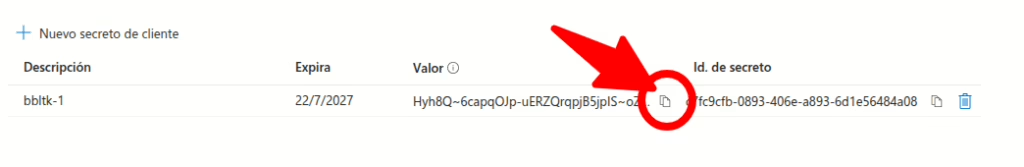

Es muy importante que copiemos el valor del secreto que lo vamos a necesitar luego

El valor del secreto no se va a poder copiar en otro momento, mejor que lo guardes ahora.

Con esto hemos terminado (en principio) con la configuración necesaria en el portal de office. Lo que hemos hecho, básicamente, es configurar los endpoints de oauth2 que podemos consultar en la opción.

Paso 2: crear un nuevo login social

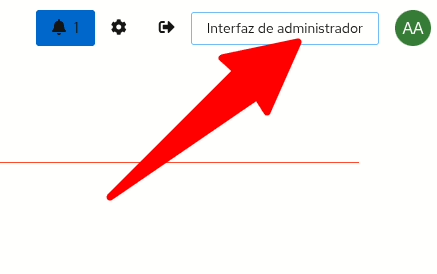

Las siguientes acciones las haremos como administrador en nuestro servidor authentik

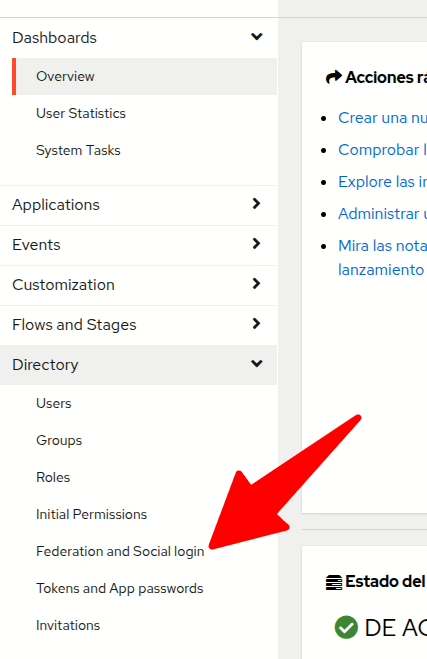

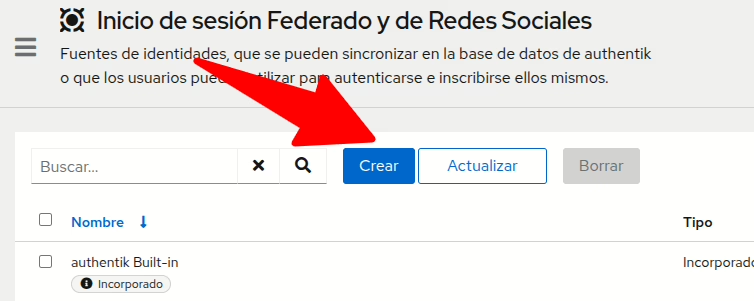

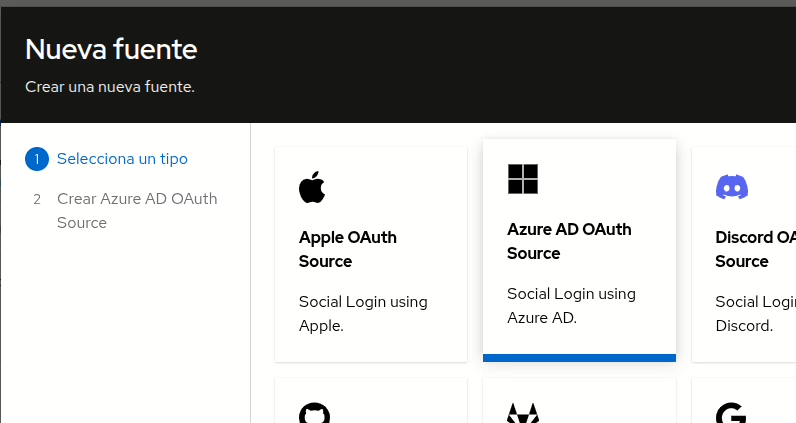

El primer paso es crear un inicio de sesión federado

del tipo azure AD

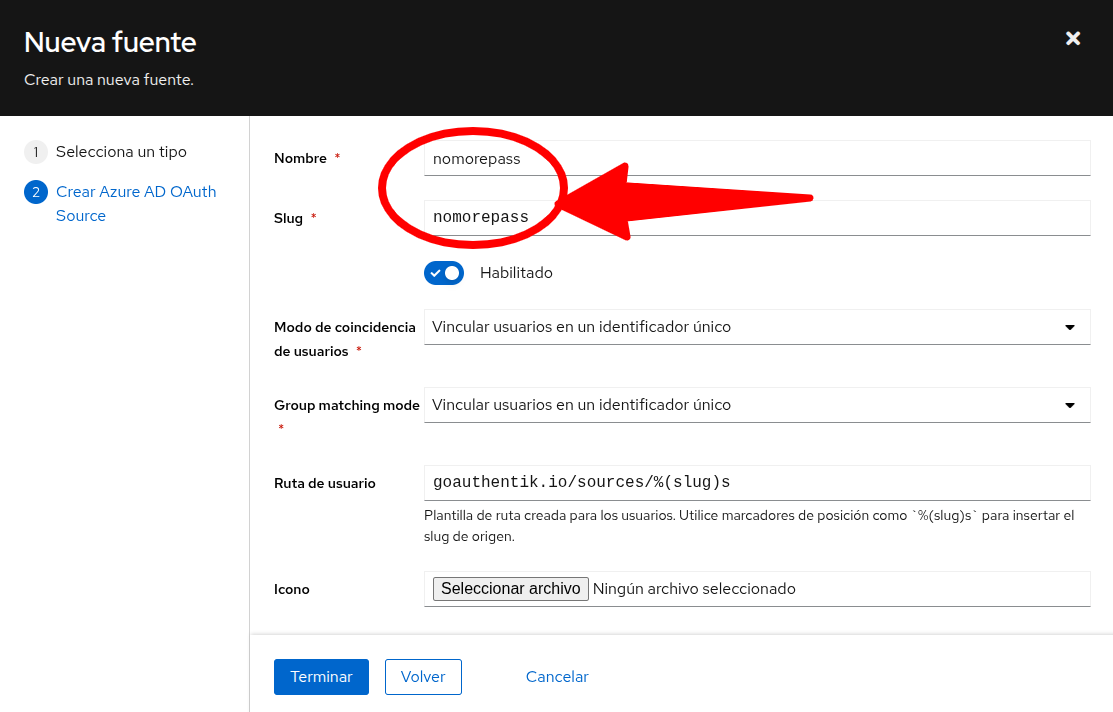

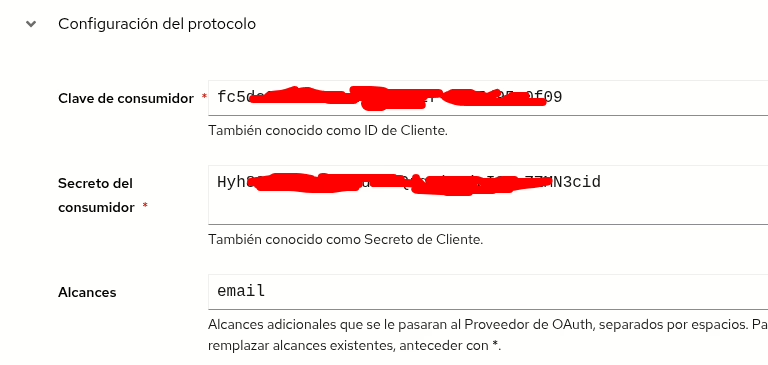

Ahora deberemos introducir todos los datos que hemos guardado al crear la aplicación en entra:

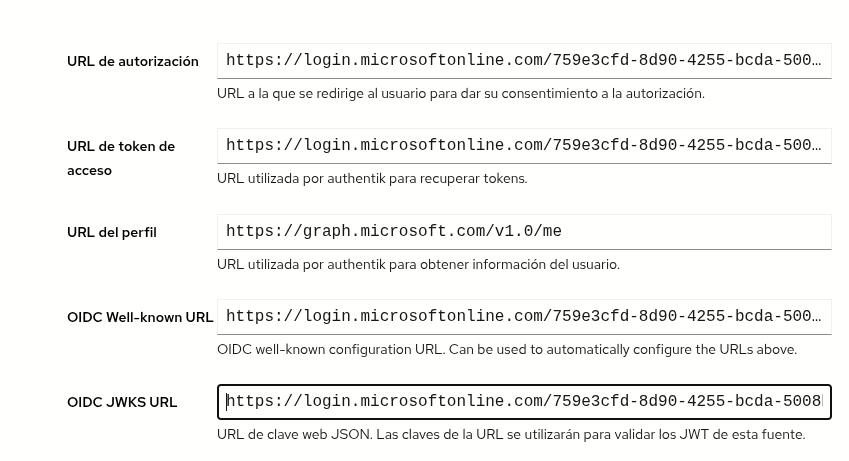

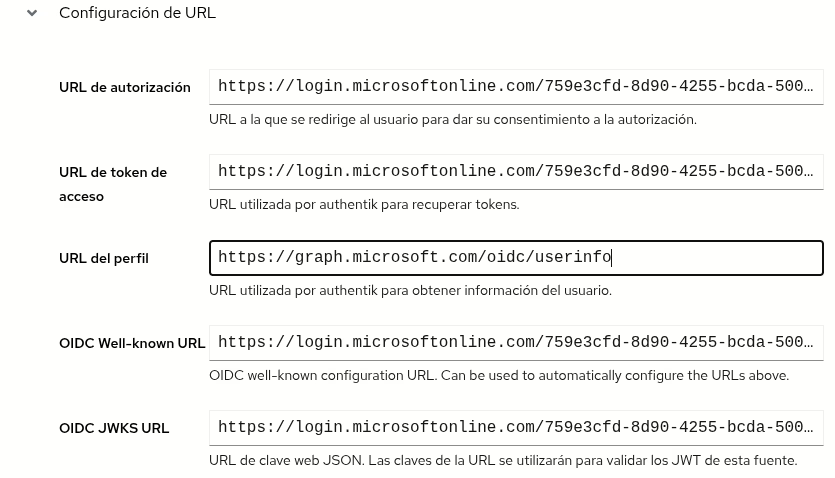

Los endpoint serán como estos (revisar los que vimos en la pantalla del portal de office):

Cambiaremos la URL del perfil a https://graph.microsoft.com/oidc/userinfo

Y damos a terminar por ahora. Esto nos configura el método para entrar usando las credenciales de Microsoft, pero todavía nos falta un par de cosas para que sea útil del todo.

Paso 3: mapeo de atributos

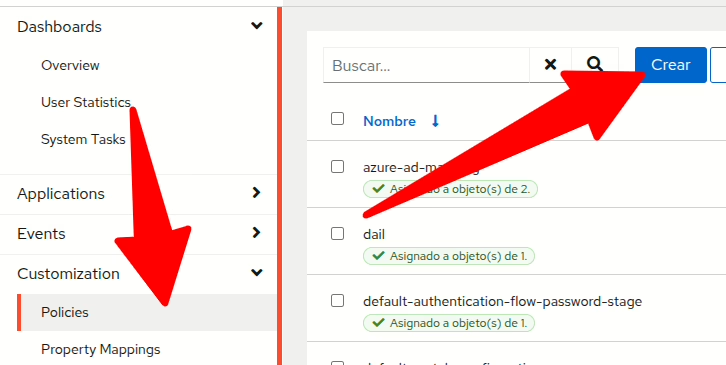

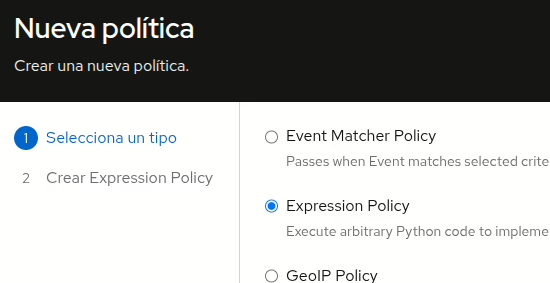

Ahora necesitamos hacer la equivalencia entre los atributos que vienen de office con los que nosotros vamos a utilizar en nuestro directorio, para eso crearemos una política de expresión:

La llamamos (por ejemplo) azure-ad-mapping y ponemos este contenido:

# save existing prompt data

current_prompt_data = context.get('prompt_data', {})

# make sure we are used in an oauth flow

if 'oauth_userinfo' not in context:

ak_logger.warning(f"Missing expected oauth_userinfo in context. Context{context}")

return False

oauth_data = context['oauth_userinfo']

# map fields directly to user left hand are the field names provided by

# the microsoft graph api on the right the user field names as used by authentik

required_fields_map = {

'name': 'username',

'email': 'email',

'given_name': 'name'

}

missing_fields = set(required_fields_map.keys()) - set(oauth_data.keys())

if missing_fields:

ak_logger.warning(f"Missing expected fields. Missing fields {missing_fields}.")

return False

for oauth_field, user_field in required_fields_map.items():

current_prompt_data[user_field] = oauth_data[oauth_field]

# Define fields that should be mapped as extra user attributes

attributes_map = {

'name': 'upn',

'sub': 'sn',

'name': 'name'

}

missing_attributes = set(attributes_map.keys()) - set(oauth_data.keys())

if missing_attributes:

ak_logger.warning(f"Missing attributes: {missing_attributes}.")

return False

# again make sure not to overwrite existing data

current_attributes = current_prompt_data.get('attributes', {})

for oauth_field, user_field in attributes_map.items():

current_attributes[user_field] = oauth_data[oauth_field]

current_prompt_data['attributes'] = current_attributes

context['prompt_data'] = current_prompt_data

return True

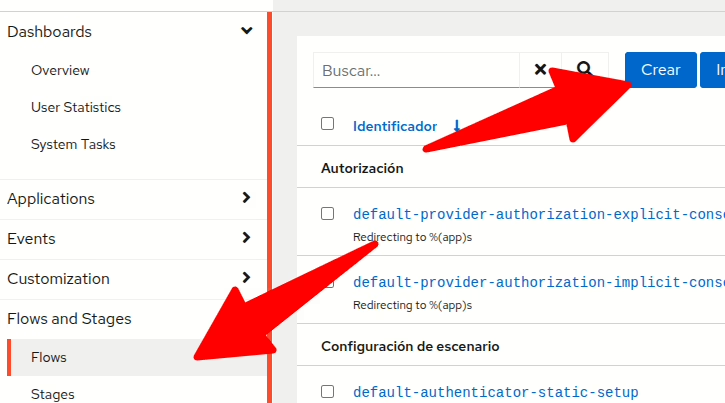

Paso 4: configurar el flujo de alistamiento

Queremos que cualquiera que tenga cuenta en el dominio office pueda entrar a nuestras aplicaciones, por lo que necesitamos registrar los usuarios nuevos cuando entran por primera vez, para ello vamos a crear uun flujo nuevo.

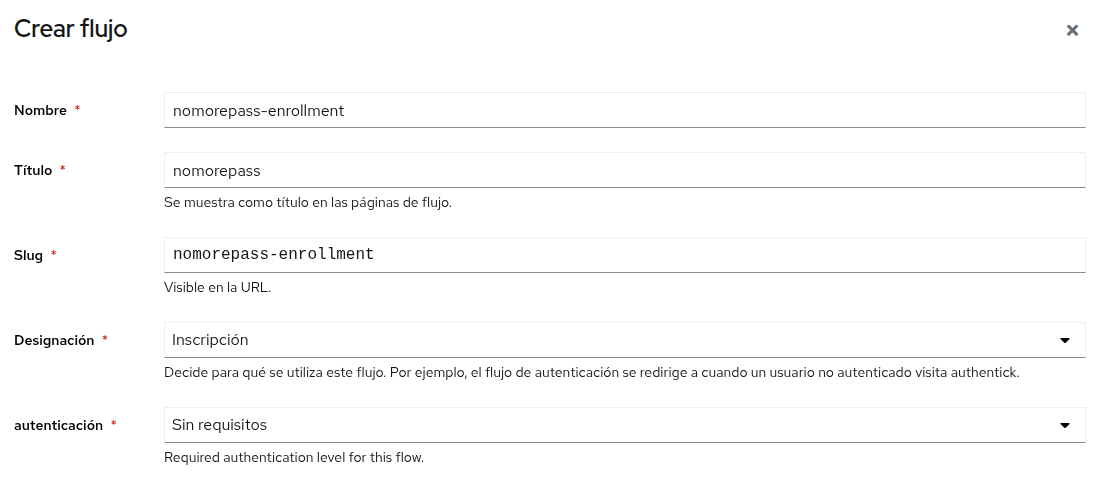

Le ponemos un nombre

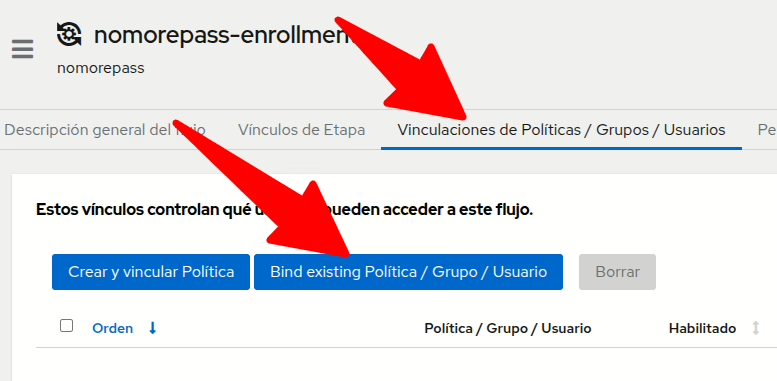

Y una vez creado, editarlo, ir a la sección d Vinculaciones de Políticas / Grupos / Usuarios y ahí a Bind existing policy

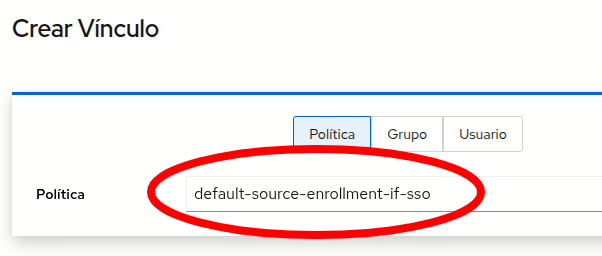

Y ahí ligar defaultsource-enrollment-if-sso

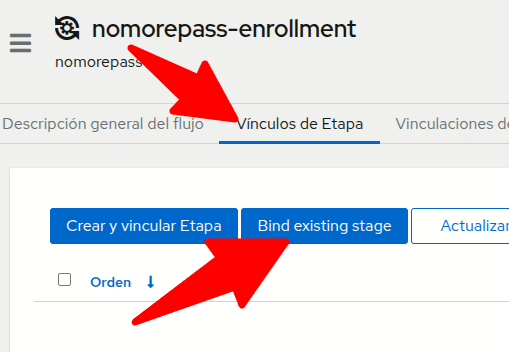

Ir ahora a vinculos de etapa -> Bind Existing stage

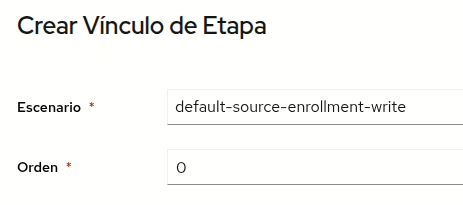

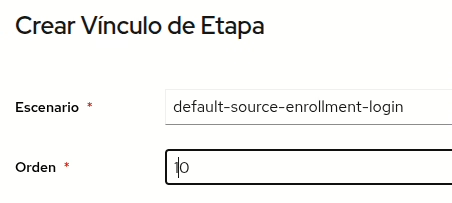

Añadir default-source-enrollment-write (orden 0) y default-source-enrollment-login (orden 10)

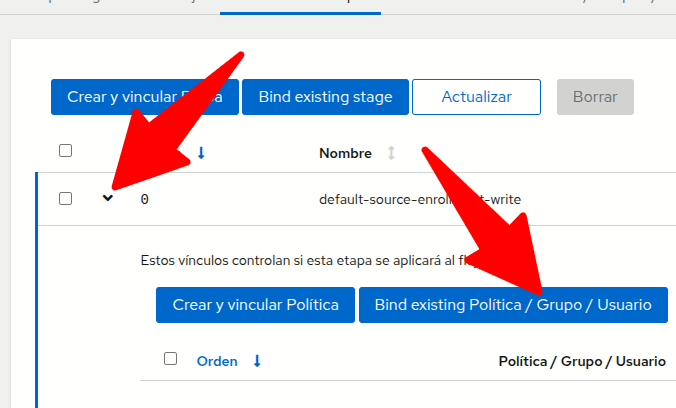

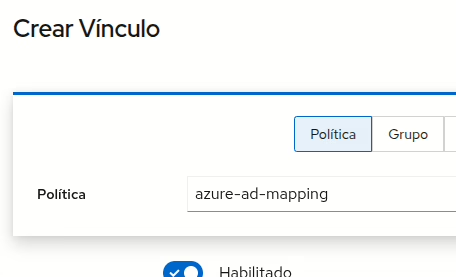

Desplegar luego la etapa con orden cero y añadir una política existente azur-ad-mapping que creamos antes:

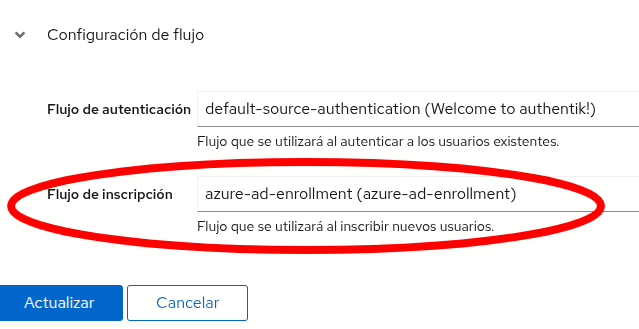

Por último editarmos la fuente que creamos al principio (Directory -> Federation ..) y le añadimos en la configuración de flujo el flujo de inscrpción a azure-ad-enrollment (o el nombre que le hayamos puesto)

Paso 5: hacer que se vea en el login

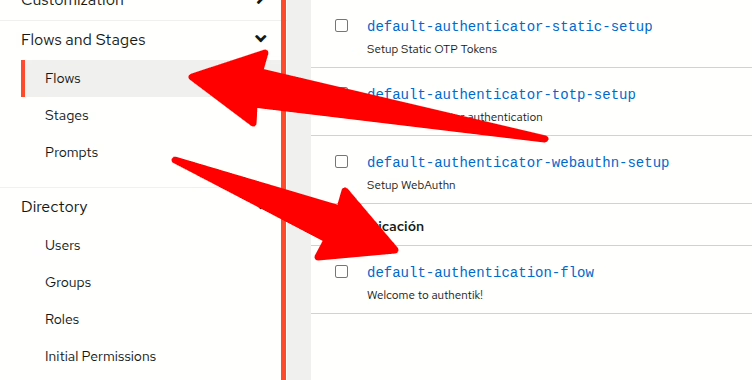

Pues ya solo nos faltaría hacer que aparezca una opción para hacer login con este proveedor, esto se hace editando el flujo default-authentication-flow

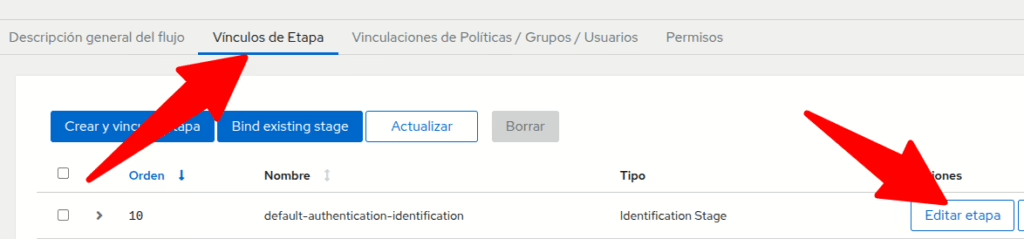

Y editas la etapa

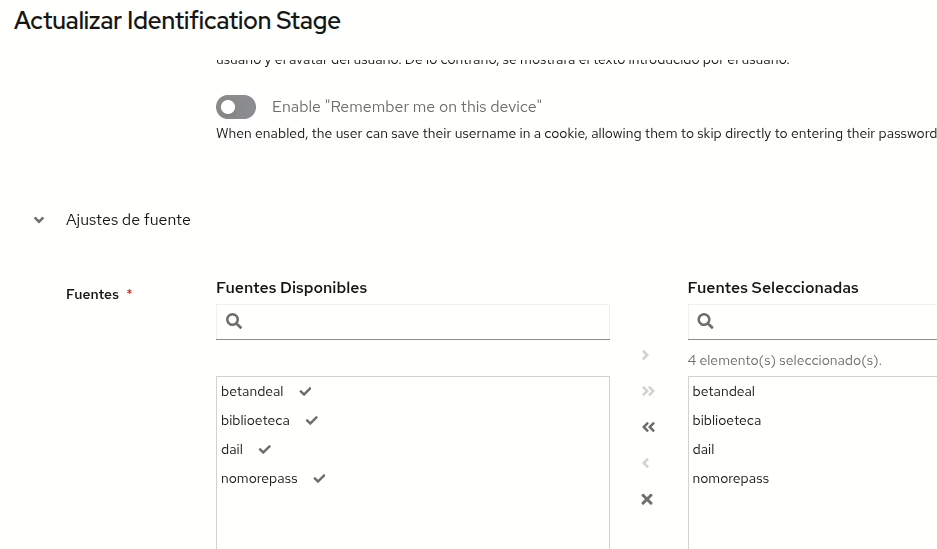

Y añades desde las fuentes disponibles a Fuentes seleccionadas

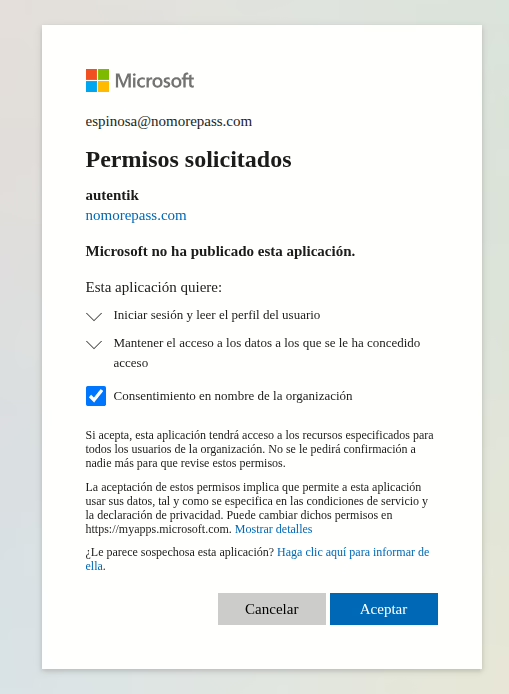

Ahora cuando entres en tu authentik ya te aparecerá la opción nueva para acceder. La primera vez que accedas debes aprobar unos permisos especiales a Microsoft:

Ha sido un proceso un poco largo, pero ahora ya tenéis centralizada la información de seguridad y cualquier aplicación que pueda conectarse a authentik podrá usar los usuarios de nuestro dominio… Ahora queda que lo probéis vosotros.