Es posible que, como nosotros, ester harto de tantas contraseñas y tantas veces que tienes que autenticarte para acceder a tus aplicaciones. Nosotros ya inventamos nomorepass para no tener que andar recordando la contraseñas, pero eso no quita a que cada vez que instalamos un nuevo sistema en nuestro laboratorio personal nos toque volver a lidiar con las credenciales de acceso. Hay veces que intentamos centralizarlo en algún proveedor externo (como google o microsoft), pero esto no es del todo seguro y corremos el riesgo de tener que andar configurando nuestras aplicaciones con credenciales que, como las de Microsoft Hello caducan cada cierto tiempo.

Por eso os propongo algo mejor, ¿porqué no hospedar nosotros nuestro propio sistema de autenticación? En este post vamos a ver como instalar y configurar uno de los más populares y potentes sistemas SSO: Authentik. La instalación es bastante sencilla y está bien explicada en su documentación. Os resumo cómo quedaría la cosa. Necesitamos:

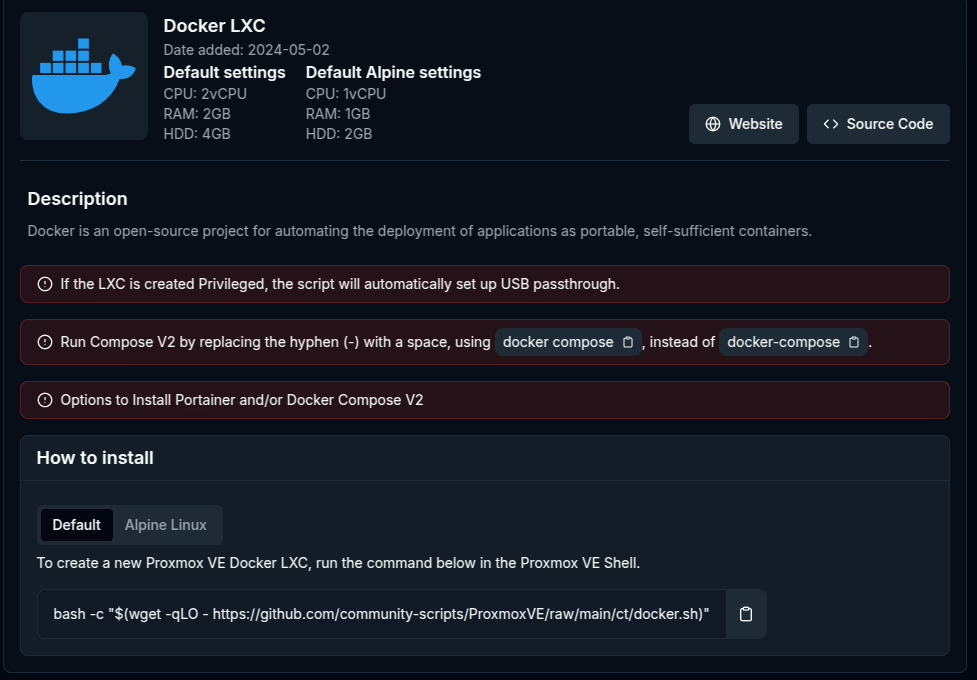

- Servidor donde instalarlo (2VCPU / 2Gb memoria mínimo)

- Docker y docker compose (v2 mejor)

- wget y openssl instalado (necesarios solo para la instalación)

Una vez que tenemos el servidor con docker y docker compose instalado nos descargamos la plantilla:

wget https://goauthentik.io/docker-compose.ymlY generamos los elementos de seguridad necesarios y los guardamos en el archivo .env

echo "PG_PASS=$(openssl rand -base64 36 | tr -d '\n')" >> .env

echo "AUTHENTIK_SECRET_KEY=$(openssl rand -base64 60 | tr -d '\n')" >> .env

Con esto ya podemos arrancar el servidor. Hay cosas que sería recomendable configurar, como la salida de email, bien con un servidor propio, o podéis utilizar cualquier servicio que os ofrezca smtp. También se puede cambiar el puerto por el que se accede, que generalmente está en el 9000/9443 para cambiarlos a los estándar 80/443. Como ejemplo os dejo mi docker-compose y mi .env (cambiando las cosas privadas, claro):

services:

postgresql:

image: docker.io/library/postgres:16-alpine

restart: unless-stopped

healthcheck:

test: ["CMD-SHELL", "pg_isready -d $${POSTGRES_DB} -U $${POSTGRES_USER}"]

start_period: 20s

interval: 30s

retries: 5

timeout: 5s

volumes:

- database:/var/lib/postgresql/data

environment:

POSTGRES_PASSWORD: ${PG_PASS:?database password required}

POSTGRES_USER: ${PG_USER:-authentik}

POSTGRES_DB: ${PG_DB:-authentik}

env_file:

- .env

redis:

image: docker.io/library/redis:alpine

command: --save 60 1 --loglevel warning

restart: unless-stopped

healthcheck:

test: ["CMD-SHELL", "redis-cli ping | grep PONG"]

start_period: 20s

interval: 30s

retries: 5

timeout: 3s

volumes:

- redis:/data

server:

image: ${AUTHENTIK_IMAGE:-ghcr.io/goauthentik/server}:${AUTHENTIK_TAG:-2025.2.4}

restart: unless-stopped

command: server

environment:

AUTHENTIK_REDIS__HOST: redis

AUTHENTIK_POSTGRESQL__HOST: postgresql

AUTHENTIK_POSTGRESQL__USER: ${PG_USER:-authentik}

AUTHENTIK_POSTGRESQL__NAME: ${PG_DB:-authentik}

AUTHENTIK_POSTGRESQL__PASSWORD: ${PG_PASS}

volumes:

- ./media:/media

- ./custom-templates:/templates

env_file:

- .env

ports:

- "${COMPOSE_PORT_HTTP:-9000}:9000"

- "${COMPOSE_PORT_HTTPS:-9443}:9443"

depends_on:

postgresql:

condition: service_healthy

redis:

condition: service_healthy

worker:

image: ${AUTHENTIK_IMAGE:-ghcr.io/goauthentik/server}:${AUTHENTIK_TAG:-2025.2.3}

restart: unless-stopped

command: worker

environment:

AUTHENTIK_REDIS__HOST: redis

AUTHENTIK_POSTGRESQL__HOST: postgresql

AUTHENTIK_POSTGRESQL__USER: ${PG_USER:-authentik}

AUTHENTIK_POSTGRESQL__NAME: ${PG_DB:-authentik}

AUTHENTIK_POSTGRESQL__PASSWORD: ${PG_PASS}

user: root

volumes:

- /var/run/docker.sock:/var/run/docker.sock

- ./media:/media

- ./certs:/certs

- ./custom-templates:/templates

env_file:

- .env

depends_on:

postgresql:

condition: service_healthy

redis:

condition: service_healthy

volumes:

database:

driver: local

redis:

driver: local

.env:

PG_PASS=<esto-lo-tienes-que-generar>

AUTHENTIK_SECRET_KEY=<esto-lo-generas-tambien>

AUTHENTIK_ERROR_REPORTING__ENABLED=true

# SMTP Host Emails are sent to

AUTHENTIK_EMAIL__HOST=mail.biblioeteca.net

AUTHENTIK_EMAIL__PORT=587

AUTHENTIK_EMAIL__USERNAME=no-reply@biblioeteca.net

AUTHENTIK_EMAIL__PASSWORD=<el que sea>

AUTHENTIK_EMAIL__USE_TLS=false

AUTHENTIK_EMAIL__USE_SSL=false

AUTHENTIK_EMAIL__TIMEOUT=10

AUTHENTIK_EMAIL__FROM=no-reply@biblioeteca.net

AUTHENTIK_TAG=2025.6.2

Si todo hay ido bien ya puedes arrancarlo:

docker compose up -d

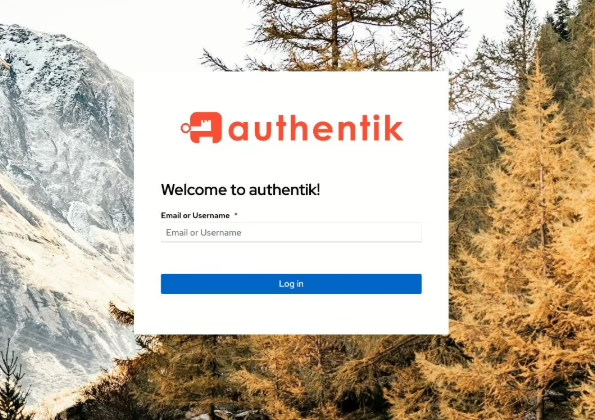

Y ya puedes empezar a configurar tu nuevo SSO navegando a la página:

http://<IP servidor>:9000/if/flow/initial-setup/Con esto ya tenemos un sistema que nos permite hacer login con los usuarios que queramos… ¿Qué más podemos hacer con este sistema?… Pues un montón de cosas. Quedaos atentos y en los siguientes posts os enseñaré como hacer cosas interesantes como conectar con sistemas externos (como office365 o google) y hacer uso de esas credenciales.