Esta semana pasada he sufrido la experiencia traumática de tener que mudarme de oficina… El casero ha dicho que no renueva el contrato y no me ha quedado más remedio que mudarme (con 14 años de trastos a mis espaldas) a otra oficina diferente… Y, aunque no soy muy tiquismiquis hay una cosa que siempre necesito… Internet.

Tengo contratado masmovil desde hace muchos años, 1Gb de fibra y una IP fija, cosas que me vienen muy bien para el tipo de cosas que tengo que hacer, y quiero seguir manteniendo estas cosas (y el número de teléfono que viene asociado a la conexión), así que indiqué a Masmovil el día del traslado y me confirmaron que ese mismo día pasaría por la nueva oficina un instalador a realizar el paso de mi conexión a esa nueva oficina.

Ahora bien, resulta que la dirección estaba mal registrada o que habían separado en oficinas lo que antes era solo un edificio o que-se-yo, el caso es que solo daba servicio movistar y el primer instalador me dijo que solicitaban el cambio y que ya me avisarían cuando estuviese la cosa. Al día siguiente me vino otro instalador que me dejó todo correctamente instalado perjurando que el instalador anterior podía haberlo hecho el otro día sin problemas (en fin…) al cabo de unos minutos ya tenía otra vez mi IP fija y mi casi-1g con los que he estado funcionando hasta ayer.

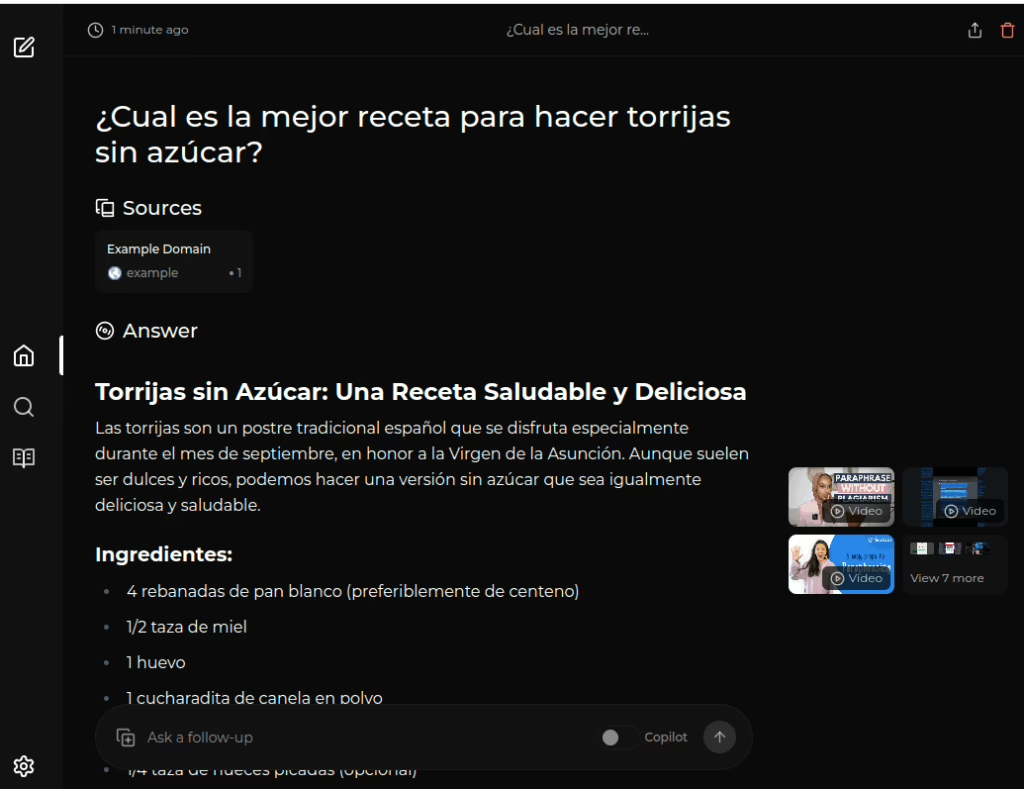

Ayer los vecinos llamaron a su instalador de movistar porque no tenían conexión y resulta que lo que pasaba es que ellos estaban (vete tu a saber porqué) enchufados a la roseta que estaba en mi oficina y, claro, al cambiarla yo el cable que iba a su router ya no estaba conectado (ni la conexión activa)… El caso es que el instalador se encabronó con el tema de tener que tirar ellos el cable otra vez (ya me dirás qué tendrían que hacer si no había fibra que llegase a esa oficina) y no se lo que hizo que me dejó a mi sin conexión (y estoy seguro que algo podría haber hecho para mantenerla). El caso es que llevo desde ayer a medio día sin conexión a internet. Puse la incidencia, me dijeron que era cosa de fuera y que ya lo arreglarían (hace más de 28 horas de eso)… Y como yo tengo que trabajar pues no me ha quedado más remedio que usar un router 4G que tenía por aquí y contratar una SIM con gigas para poder tener algo de internet mientras tanto.

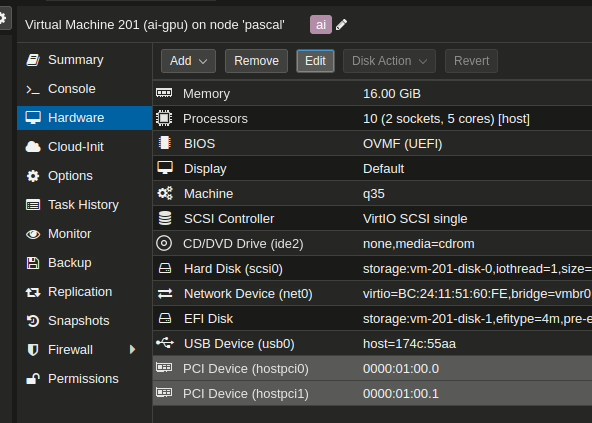

Como la wifi solo la puedo usar desde móviles y portátiles y yo quería usar mi torre (y tener conectividad en general) me puse a ver si era sencillo poner esa conexión como fallback en el router opnsense que monté con un ordenador chino (bastante bueno y con dos puertos SFP+ que me permiten llegar a 10Gb)… Y si, después de penar un poco (porque hay cosas que no están bien pulidas del todo) conseguí hacerlo funcionar. Estos son los pasos que di:

1.- Enchufar el router 4G a la salida ethernet que tenía libre mi ordenador-router (os pongo la foto de uno parecido)

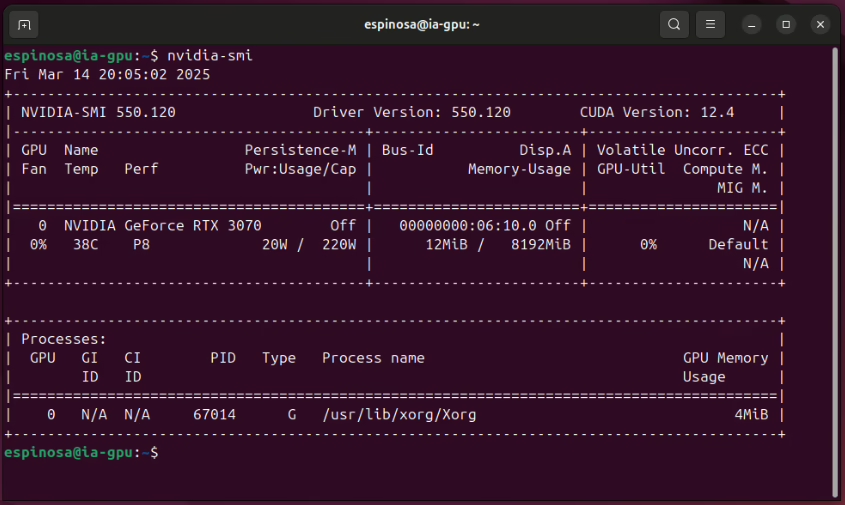

En eth0 estaba el router de masmovil configurando este como DMZ para poder recibir el tráfico entrante y en eth1 la nueva conexión.

En SPF0 tenía conectado el router del resto de mi red.

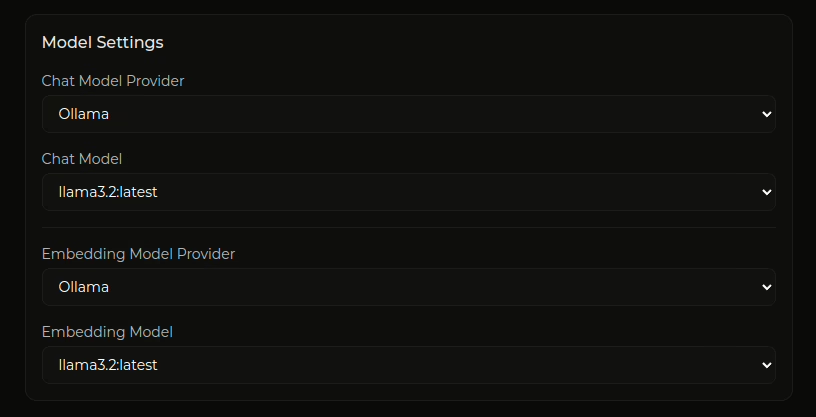

2.- En opnsense doy de alta el interfaz nuevo (en este caso por dhcp)

3.- En System > gateways > configuration creo un gateway nuevo, le digo que active la monitorización del gateway y le pongo la IP de un servidor dns fiable (como 8.8.4.4) y le pongo como IP la IP del router 4G (192.168.0.1 en mi caso).

4.- El gateway existente lo modifico para habilitar el monitoreo y añado como IP la 8.8.8.8 (puede ser cualquiera mientras sea diferente de la anterior)

5.- En system > settings > general añado estos dos DNS como DNS Servers y les asocio a cada uno el gateway correspondiente y activo la opción «Allow default gateway switching»

6.- En System > gateway > group creo un grupo nuevo, le pongo un nombre y hago que el interfaz de la WAN principal sea Tier1 y de la secundaria Tier2, ponemos Trigger Level a «Packet Loss or high latency» y una descripción adecuada (yo también puse Pool Options a Round Robin, pero eso no es tan importante)

7.- En Firewall > rules > LAN (o como llaméis a vuestro interfaz de red local) modificamos la configuración de la regla genérica que permite todo para indicar que el gateway será el nuevo grupo que acabamos de crear

8.- Por último, y esto lo he descubierto después de mucho tiempo, la generación automática de reglas NAT > Outbound no es perfecta y tuve que añadir una regla para que permitiese todo el tráfico desde la WAN2 indicando que su dirección de NAT sería la de WAN2

Y, en principio, esto es todo… Haced vuestras pruebas de ping, mtr y demás y veréis que cuando está caída la conexión principal saldréis a internet por la secundaria… Espero que masmovil me lo arregle pronto que los GB de la tarjeta sim ya se me están gastando. Grrr.